深入理解黄仁勋的GTC主题演讲:重新审视Scaling Law

近日,英伟达CEO黄仁勋在GTC(GPU Technology Conference)主题演讲中,就人工智能领域的Scaling Law(规模定律)提出了颇具争议的观点,引发了业界的热议。本文将深入分析黄仁勋的演讲内容,并结合相关资料,对Scaling Law进行重新审视。

什么是Scaling Law?

Scaling Law是指随着系统规模的扩大,系统的性能、能耗等指标会呈现出一定的规律性变化。在人工智能领域,Scaling Law主要体现在模型规模与计算资源、性能之间的关系上。简单来说,更大的模型需要更多的计算资源,但也能带来更好的性能。

黄仁勋对Scaling Law的看法

黄仁勋在GTC演讲中表示,当前业界对Scaling Law的理解存在误区。他认为,单纯追求模型规模的扩大并不是最优解,而是应该关注模型规模、算力和数据反馈之间的平衡。

1. 算力的提升

黄仁勋强调,算力的提升是提高AI模型性能的关键。英伟达在GPU领域的领先地位,就是得益于其在算力提升方面的不断创新。他还介绍了英伟达最新的 Blackwell Ultra架构,表示其性能有望翻倍。

2. 数据反馈的作用

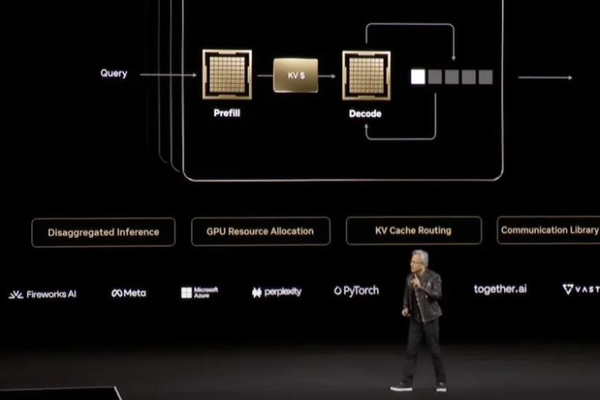

黄仁勋认为,在AI模型的训练和推理过程中,数据反馈起着至关重要的作用。通过不断地获取和利用数据反馈,模型可以不断地优化和提高性能。他强调,数据反馈和算力一样,都是提高AI模型性能的关键因素。

3. 模型规模、算力和数据反馈的平衡

黄仁勋表示,单纯地追求模型规模的扩大并不是最优解。而是应该关注模型规模、算力和数据反馈之间的平衡。他提出,未来AI发展的三大驱动力是:算力的提升、测试时计算和推理过程中的数据反馈。

重新审视Scaling Law

黄仁勋的观点引发了业界对Scaling Law的重新审视。一些研究表明,单纯地追求模型规模的扩大并不是提高性能的最优解。例如,一项研究发现,在某些情况下,小模型在性能上甚至优于大模型[1]。

同时,数据反馈在AI模型的训练和推理过程中起着至关重要的作用。通过不断地获取和利用数据反馈,模型可以不断地优化和提高性能。因此,关注模型规模、算力和数据反馈之间的平衡,是提高AI模型性能的关键。

黄仁勋的影响力

黄仁勋作为英伟达的领军人物,一直受到业界的瞩目。他的演讲和观点备受关注,并对业界产生了深远的影响。例如,他在2016年GTC大会上提出的“深度学习是未来”的观点,就引发了业界对人工智能的广泛关注和讨论。

结语

黄仁勋在GTC主题演讲中对Scaling Law的看法,为业界提供了新的思考和方向。重新审视Scaling Law,关注模型规模、算力和数据反馈之间的平衡,是提高AI模型性能的关键。未来,业界需要不断地探索和创新,才能推动AI技术的发展和应用。

参考资料来源

[1] Frankle, J., & Carbin, M. (2019). The Lottery Ticket Hypothesis: Finding Sparse, Trainable Neural Networks. arXiv preprint arXiv:1803.03635.

GTC 2023:黄仁勋解读Scaling Law,英伟达AI前景何去何从?

英伟达GTC2023:黄仁勋解读Scaling Law,AI未来发展三大驱动力